类型:体育竞技

语言:简体中文

更新:2025-12-31 06:12:20

大小:9.9MB

平台:Android

- 最热游戏

- 最新游戏

-

樱花校园模拟器十八汉化版 v1.032.1001

-

王者霸业传奇手游官网版 v5.5.002

-

星球爆炸模拟器安卓版 v1.1.403

-

小舞奇遇记3d免费版 v01.28.0304

-

鸣人的假期 v10000005

-

火柴人联盟 v5.9.906

-

lastdayonearth v307

-

ankhazone埃及猫 原版v0.0.108

-

gta4手机版 v309

-

hypnoapp安卓版 v1.1.010

- 游戏介绍

- 游戏截图

- 专题合集

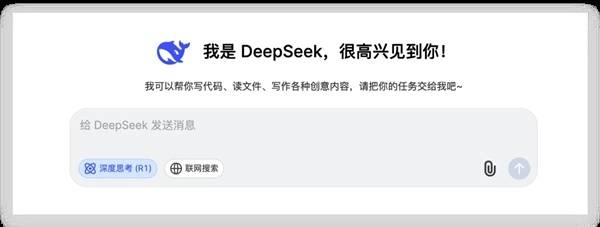

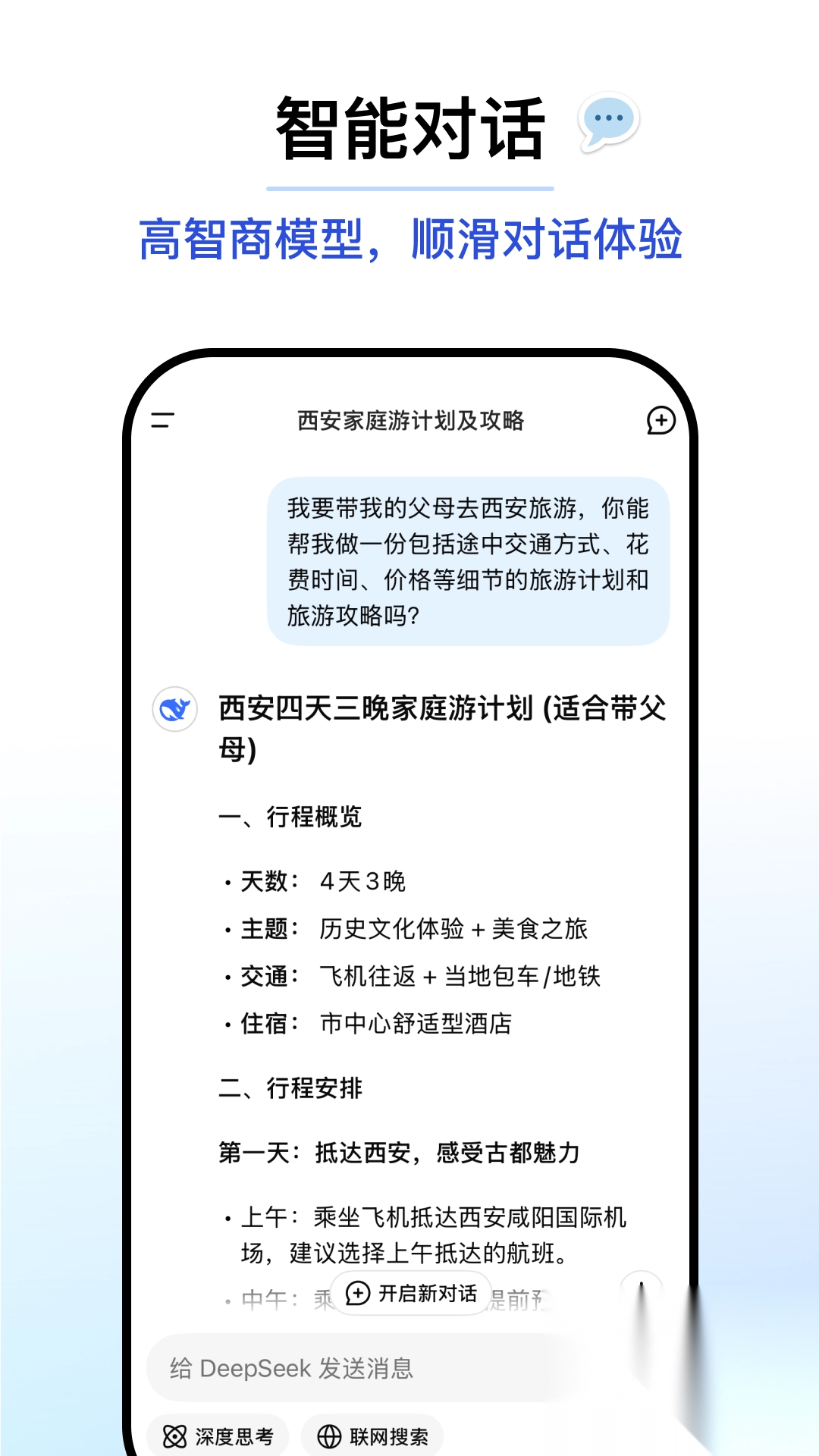

DeepSeek最新版本属于AI对话类应用,其核心目标是借助智能交互形式,协助用户解决AI及相关领域的知识疑问。用户仅需在该应用中输入问题,AI就能快速给出对应的解答和关联信息。该应用采用自定义接口的架构设计,让用户不必经历复杂的充值或注册步骤,就能直接开启使用,有效优化了用户的使用感受。

说明

DeepSeek深度求索是一款AI对话软件,它能够为你解答各类AI相关的知识。无论你想了解什么内容,只需通过这款软件进行提问,它就会为你提供解答。这是一个自定义接口,无需充值即可直接使用,十分便捷。

应用优势

分析用户行为和偏好,推荐最相关的内容和信息。

自动生成高质量的文章和内容。

高效回答用户咨询和问题。

在编程相关的多个专业方向,比如各类程序设计语言的运用、算法逻辑的构建以及数据结构的实现等方面,我们能够为用户提供具体的代码编写范例,并且在代码调试过程中给予针对性的协助与指导。

DeepSeek怎么注册登录

进入软件后我们需要完成登录;

未注册的账号将自动完成注册;

登录完毕以后就可以正常使用此软件了。

DeepSeek R1本地部署教程

一、网页端使用

最简便的方式是通过网页使用。你可以直接打开网页,也可以在应用商店里搜索对应的App。

您可以通过访问深度求索的对话平台链接来使用相关服务,该平台的网络地址为https://chat.deepseek.com/。

【深度思考】,就是R1的推理模型,可以自动思考。

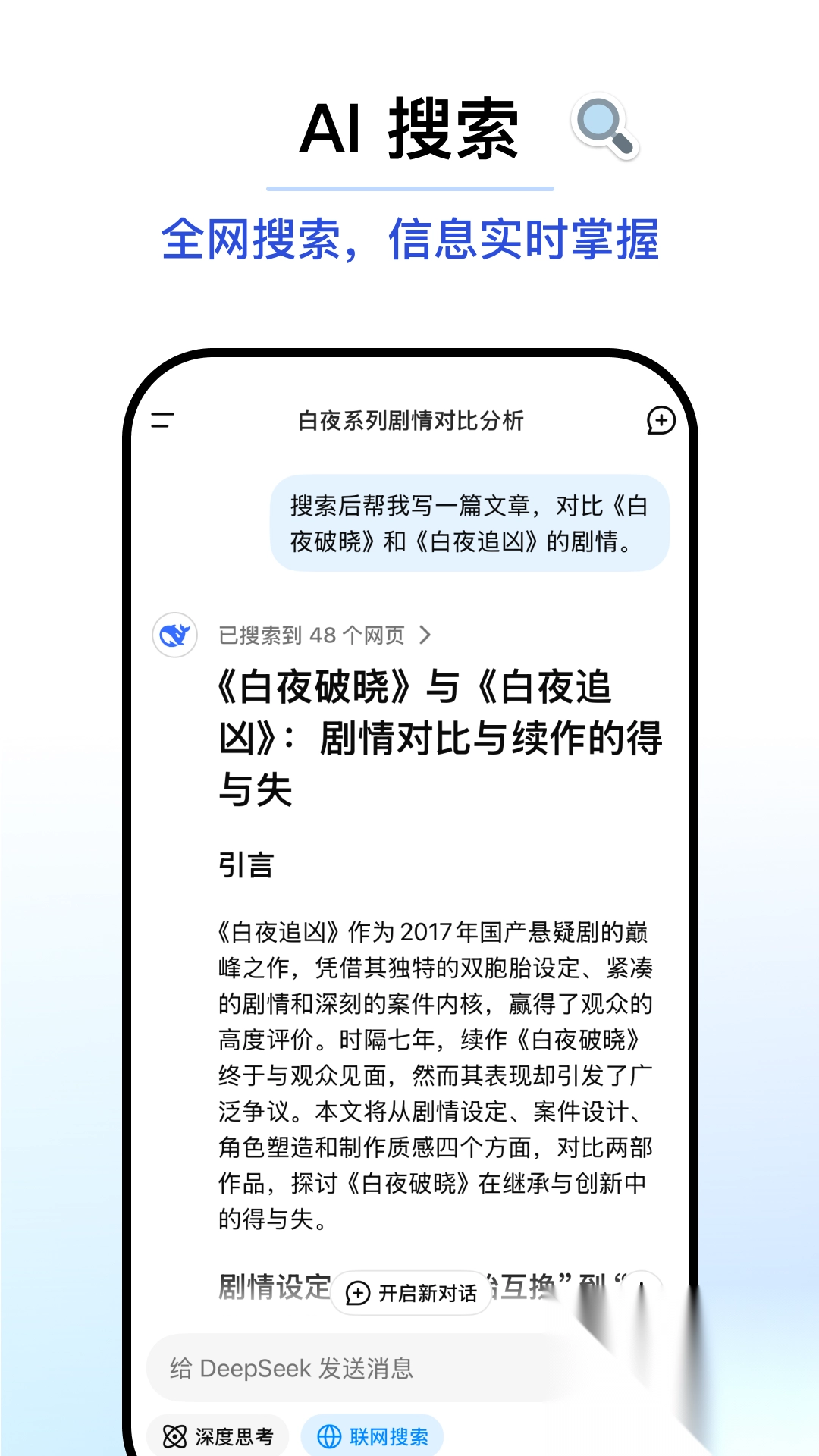

【联网搜索】,能够搜索到近期最新的内容,尤其是查看最新的新闻。

选择文件(右下角),例如图片、文档之类的,使其提取图片或文档里的文字内容。

最近Deepseek的服务器访问量激增,频繁出现故障提示导致无法正常使用;这种情况下本应通过API来解决,但目前Deepseek API也处于不可用状态。

要是你平时玩游戏,或者电脑上配有专门的显卡,完全可以自己在本地进行部署。

如果你没有显卡,可以借助第三方API来实现需求,它的运行速度相当快,功能也很强大;尽管和显卡直连的性能存在些许差距,但对于日常使用场景来说已经完全足够了。

然后使用第三方的客户端连接就可以使用。

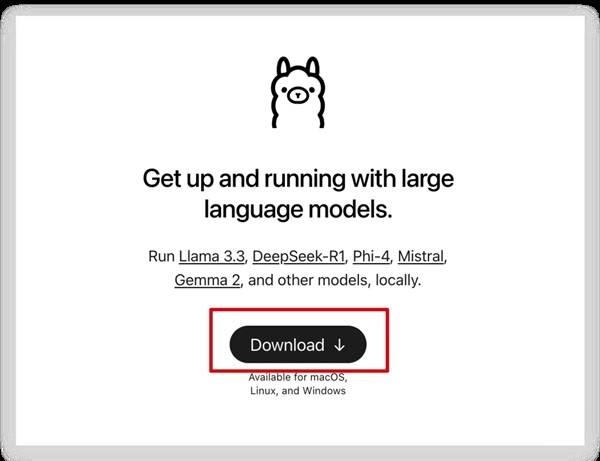

二、本地安装Deepseek R1

Ollama本地安装Deepseek R1 模型

Ollama 的官方网站地址是:https://ollama.com/

打开,然后点击,之后安装到本地。

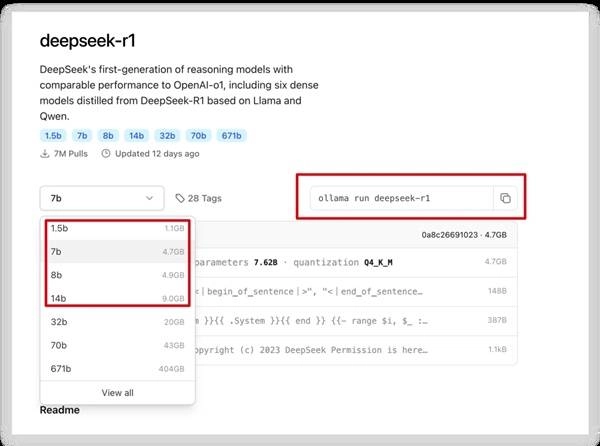

接着进入Ollama的模型目录,找到DeepSeek R1这个模型。

这是一个指向特定AI模型资源页面的网络链接,该模型来自DeepSeek系列,可在Ollama平台的模型库中找到并获取。

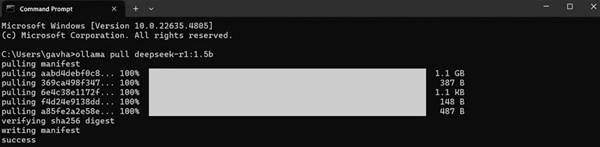

普通电脑配置下,1.5B和7B这类模型就能顺利运行,操作时只需复制界面右上角的代码,再到命令行里执行即可。

安装过程需要稍作等待,等看到success字样出现时,就说明安装已经顺利完成了。

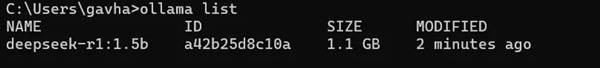

输入【ollama list】命令,就能查看已安装的模型。

设置安装完成后,我们只能通过命令行来使用,这会特别不方便。

我们需要找到一个第三方客户端。

第三方客户端

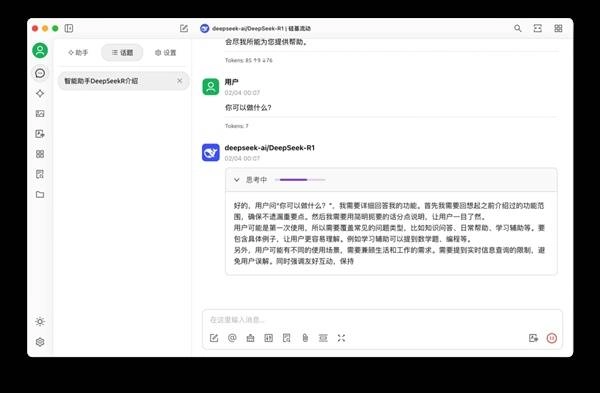

客户端这边有两款不错的工具推荐,分别是Chatbox和Cherry Studio,它们的表现都很出色。帅客会选用Cherry Studio来进行演示操作。

樱桃工作室的官方网站地址是:https://cherry-ai.com/

有一款名为Cherry Studio的AI客户端功能十分出色,它能够兼容国内外众多不同的模型。

还很多提示词,文生图,文档等功能。

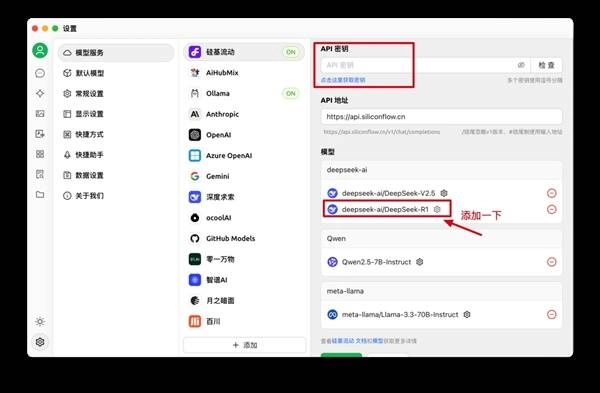

按照下面步骤添加即可。

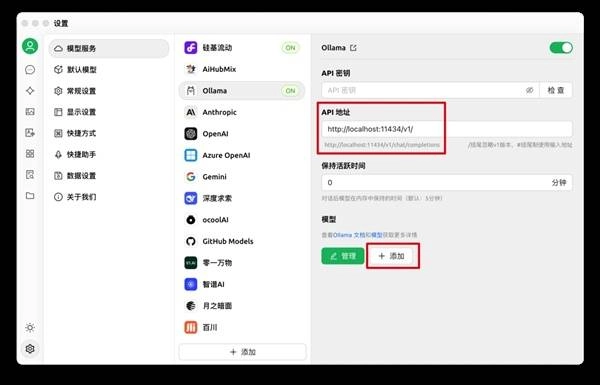

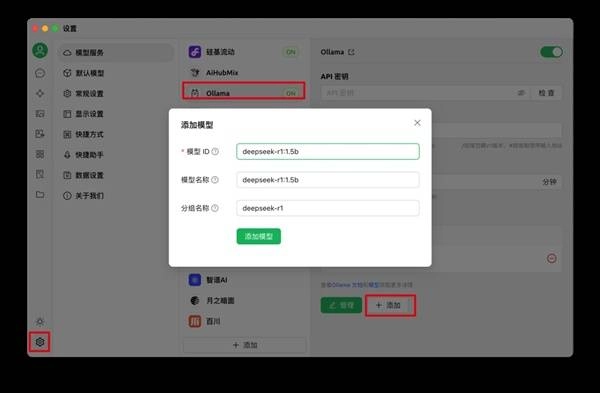

我们在Cherry Studio客户端中,对Ollama已安装的模型进行配置。

系统默认的API地址为本地主机11434端口下的v1版本接口路径。

模型名:deepseek-r1:1.5b

第三方API

若设备未配备GPU,本地部署可能存在性能瓶颈,更推荐通过API调用的方式来实现相关功能。

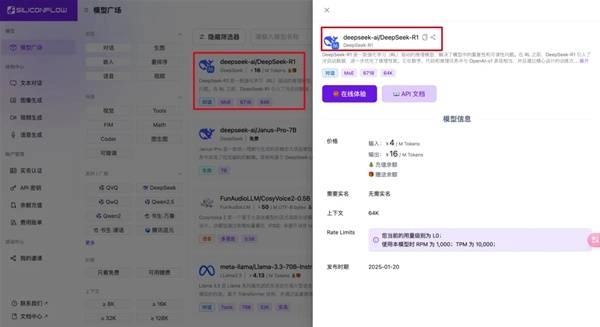

我们使用【硅基流动】来给大家举例子。

您可以通过访问硅基流动云平台的官方网址来使用相关服务,该网址为:https://cloud.siliconflow.cn

首先得注册一个账号,注册就送14块,能用挺长时间的。

接着打开【模型广场】,找到Deepseek R1,要复制对应的模型。

接下来打开API Key页面,访问链接https://cloud.siliconflow.cn/account/ak,创建一个api-key,之后再打开Cherry Studio。

模型配置完成后,进入对话界面,在顶部菜单栏选择R1模型就能直接使用,体验十分流畅便捷。

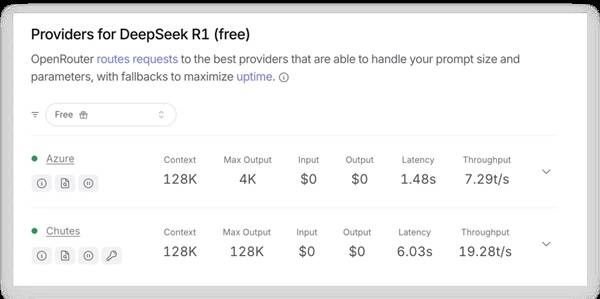

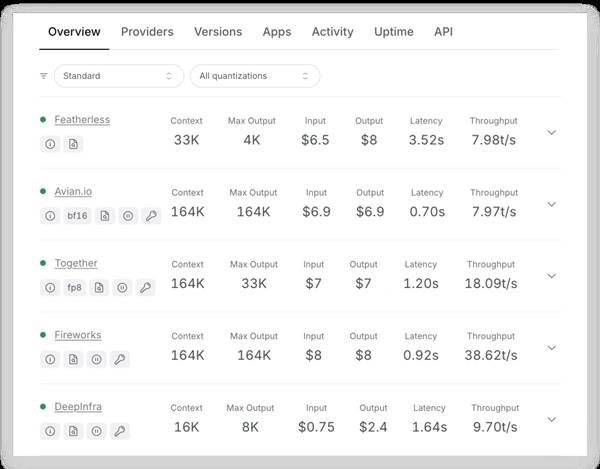

免费API

大家要是想找免费或价格实惠的选项,可以在这个网站上查询,它能对比各类价格。另外这里还有免费资源,目前有两种免费方式可供使用。

这里有一个指向特定AI模型服务页面的链接,该模型由一家科技公司开发,用户可以通过此链接访问并使用该模型的免费版本服务。

不过其他提供API的价格依旧很实惠,大家可以先拿来用用。

目前对比下来,不少商品的定价依然偏高;待接口功能恢复后,价格应该会快速回落至更实惠的区间。

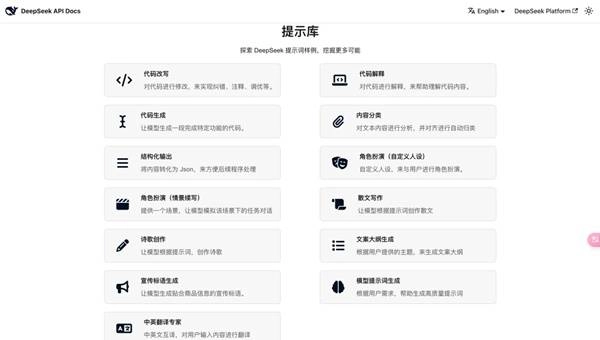

Prompt

https://api-docs.deepseek.com/prompt-library

这是一个由深度求索推出的提示词资源平台,上面整合了不少同类站点的内容,有需要的朋友可以去看看作为参考。

可以让它生成提示词,还可以扮演各种角色,格式化输出,代码改写,仿写功能。

使用Deepseek R1时,要清晰给出【关键词】,提供【上下文】信息,注意规避【歧义】问题;若内容涉及时效性,需开启联网功能。

deepseek r1和v3的区别

设计目标

R1 是一款以推理性能为核心优势的模型,它的设计初衷是高效应对各类复杂推理场景,尤其适用于那些对深度逻辑剖析与问题解决能力有较高要求的应用领域。

第三版模型定位为通用性强的大型语言模型,核心聚焦于拓展能力与高效运算,旨在让其能在各类自然语言处理场景中,达成既高效又具备灵活适配性的应用效果。

架构与参数

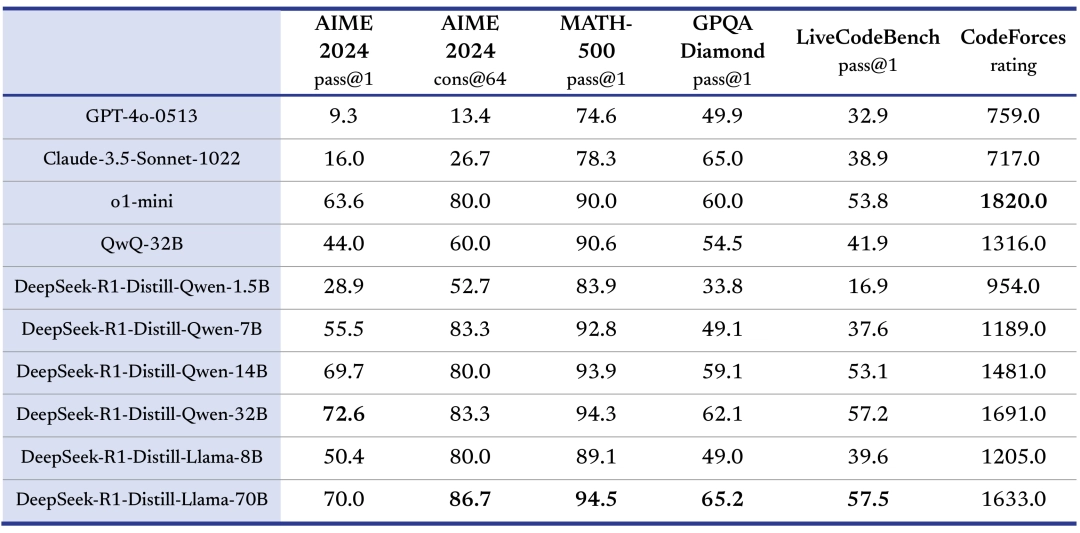

首个迭代版本采用了强化学习驱动的架构优化方案,同时提供了多档参数规模的蒸馏模型,其参数数量覆盖了从十亿级到数百亿级的区间。

最新迭代的模型采用混合专家架构设计,整体参数规模达六千七百一十亿,在处理每个token时会激活三百七十亿参数。

训练方法

R1版本在训练过程中强调思维链(CoT, chain of thinking)推理能力的培养,其中R1-zero是纯强化学习训练的版本,而R1则在其基础上额外加入了监督微调(SFT, supervised fine tuning)阶段。

V3版本在训练时运用了FP8混合精度技术,整个训练流程划分为三个阶段:首先是高质量基础训练阶段,接着是扩展模型处理序列长度的阶段,最后是通过监督微调(SFT)与知识蒸馏技术完成后训练的阶段。

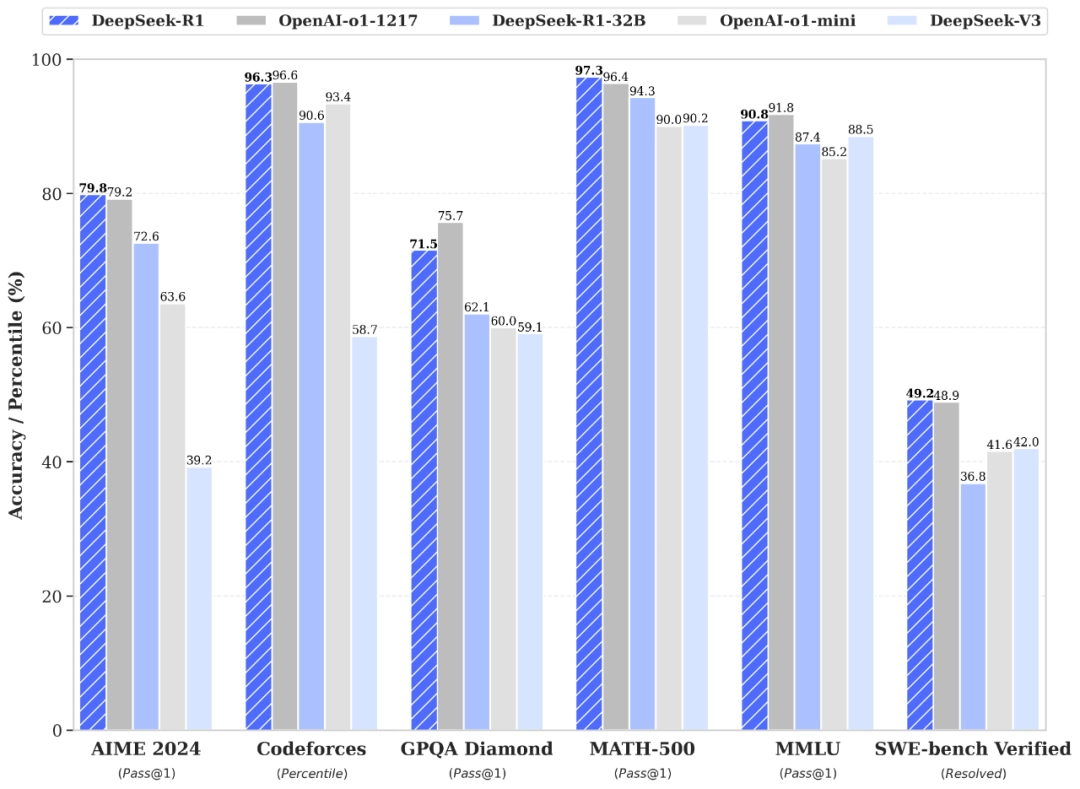

性能表现

R1版本在逻辑思维相关的基准测试中展现出优异表现,例如在DROP任务里F1分数取得92.2%的成绩,在AIME2025中的通过率达到79.8%。

最新迭代的模型在数理运算、跨语种处理及代码编写等领域展现出强劲实力,例如在特定数学测评中取得超九成的成绩,在专业编程任务里的代码通过率也超过了六成五。

应用场景

R1版本:适用于学术研究、问题解决类应用程序以及决策支持系统等对深度推理有需求的任务,同时也适合充当教育工具,助力学生开展逻辑思维训练。

V3迭代版本主要面向大型自然语言处理场景,像智能对话系统、跨语言互译工具以及文本内容创作平台等领域,可为各类企业打造高效的人工智能服务方案,助力其覆盖多元业务场景的应用需求。

关于我们

这款智能对话工具具备丰富的功能矩阵,覆盖自然语言交互相关的各类场景需求。它能精准捕捉用户意图,无论是日常闲聊、专业知识检索,还是具体事务办理,都能给出贴合需求的回应。在语言适配方面,支持多语种交流,还能感知用户的情绪状态,动态调整对话的语气风格。此外,它还提供文件交互能力,可对上传的图片或文档进行文字提取与解析。

DeepSeek Coder聚焦于编程代码的生成、调试与优化工作。其编程能力得到了明显增强,可针对编程过程中的瓶颈问题给出多种解决办法。该模型能够支持代码优化和重构任务,有助于提升代码的可读性与可维护性。同时,它的训练成本较低,还具备大规模数据处理的能力。

DeepSeek R1具备模型蒸馏能力,由此得到的1.5B、7B、8B、14B等小参数模型十分适配本地部署场景,对于资源相对紧张的中小企业与开发者而言尤为适用。该模型以强化学习(RL)为技术驱动力,重点发力数学和代码推理领域,能够支持长链推理(CoT),可有效应对各类复杂逻辑任务。

DeepSeek-R1已正式发布,其性能目标直指OpenAI o1正式版

一款名为DeepSeek V3的模型,其总参数量达到671亿,而实际激活的参数为37亿。该模型在14.8万亿个高质量训练数据片段上完成了预训练过程,整体性能处于开源模型中的领先地位,甚至超过了包括Llama 3.1 405B和GPT-4o在内的多个顶尖模型,尤其在数学相关任务上展现出显著优势。值得注意的是,其训练过程的投入成本约为558万美元,较传统大模型训练成本有明显下降。此外,该模型采取完全开放的策略,训练过程的相关细节也对外公开。

DeepSeek V2的参数量达到236亿,其中激活参数为21亿。该模型支持128K的上下文窗口,不仅显存占用较少,而且每token的成本也显著下降。

性能对齐 OpenAI-o1 正式版

DeepSeek-R1 在后续的训练阶段中,大规模应用了强化学习技术,即便仅依靠少量标注数据,也显著增强了模型的推理能力。在数学、代码编写、自然语言推理等各类任务中,其性能已能与 OpenAI o1 正式版相媲美。

蒸馏小模型超越 OpenAI o1-mini

我们在开源DeepSeek-R1-Zero与DeepSeek-R1这两个660B模型的同时,借助DeepSeek-R1的输出结果,蒸馏出6个小模型并开源给社区,其中32B和70B规格的模型在多项能力指标上达到了可对标OpenAI o1-mini的水平。

开放的许可证和用户协议

为了推动并激励开源社区与行业生态的发展,在发布R1并将其开源的同时,我们也同步在协议授权方面做出了如下调整:

我们决定将所有开源模型的授权协议统一调整为MIT License。此前,考虑到大模型开源的特殊性,我们参考行业常见做法引入了DeepSeek License,希望为社区提供适配的授权方案,但实际应用中发现非标准化协议可能提升了开发者的理解门槛。因此,本次所有开源资源(涵盖模型权重文件)将全面采用MIT这一标准化、低限制的协议,确保完全开放且不设商用壁垒,开发者可直接使用无需额外申请。

产品协议中已明确包含“模型蒸馏”相关内容。为了更有力地推动技术的开源与共享,我们决定为用户开展“模型蒸馏”提供支持。目前,我们已对线上产品的用户协议进行了更新,清晰地允许用户借助模型输出,通过模型蒸馏等途径来训练其他模型。

DeepSeek App与网页端

登录DeepSeek或App,开启“深度思考”模式,就能调用最新版DeepSeek-R1来完成各类推理任务。

推荐理由

可以精准把握自然语言的含义并进行生成,具备语言翻译、文本摘要、情感分析、命名实体识别等多种功能。

回答各种问题,包括常识性和专业领域的问题。

理解用户语言和意图,提供个性化的对话体验。

用户评论

具体评论内容

请输入手机号码

风火轮赛车 v1.0

风火轮赛车 v1.0

逆战先锋手机版 v1.0.0 安卓版

逆战先锋手机版 v1.0.0 安卓版

全明星街球派对正版 V1.0.294088

全明星街球派对正版 V1.0.294088

机器人变形金刚大战 v1.29 安卓版

机器人变形金刚大战 v1.29 安卓版

强光暗战 v1.0 安卓版

强光暗战 v1.0 安卓版

杰克最强跑酷 v1.0.1 安卓版

杰克最强跑酷 v1.0.1 安卓版

不服就来战 v1.5.0 手机版

不服就来战 v1.5.0 手机版

我要当国王刺杀国王 v1.1.2 安卓版

我要当国王刺杀国王 v1.1.2 安卓版

传球进球 v0.2 安卓版

传球进球 v0.2 安卓版

极简高尔夫 v1.1.4 安卓版

极简高尔夫 v1.1.4 安卓版

SuperStick v1.1.000 安卓版

SuperStick v1.1.000 安卓版

保龄球狂怒 v0.6.1.2019 安卓版

保龄球狂怒 v0.6.1.2019 安卓版

画线踢球 V1.2

画线踢球 V1.2

台球大师模拟器 V2.0.4

台球大师模拟器 V2.0.4

物种进化史 V1.0.9

物种进化史 V1.0.9

疯狂的自行车跑酷 V1.3.0

疯狂的自行车跑酷 V1.3.0

3D台球 V2.2.4.2

3D台球 V2.2.4.2

疯狂篮球高手 V1.9

疯狂篮球高手 V1.9

足球梦想 V1.221.5

足球梦想 V1.221.5

保龄球队 V1.25

保龄球队 V1.25